روابط عمومی شرکت ایدکو (توزیعکنندهی محصولات کسپرسکی در ایران)؛ اوایل آگست 2021 اپل از سیستم جدید خود برای شناسایی عکسهای حاوی تصاویر سوءاستفاده از کودکان رونمایی کرد. گرچه انگیزههای اپل –مبارزه با اشاعه پورنوگرافی- به نظر نشان از حسن نیت این شرکت داشت؛ اما زود مورد انتقاد قرار گرفت. اپل مدتهاست از خود چهرهای ساخته محافظ حریم خصوصی کاربر. قابلیتهای جدیدی که برای آیاواس 15 و iPadOS 15 انتظار میرفت تا همین الانش مغایر با خطمشی اپل بوده است اما گویا این شرکت قصد عقبنشینی ندارد. در ادامه با ما همراه شوید تا توضیح دهیم اپل چطور قصد دارد کاربران خود را مورد نظارت قرار دهد.

شناسایی CSAM چیست؟

برنامههای اپل در وبسایت اپل عنوانبندی شده است. این شرکت سیستمی را طراحی کرده به نام CSAM Detection که کارش جستجوی دستگاههای کاربران برای متریال سوءاستفاده جنسی از کودکان است. گرچه پورنوگرافی کودکان مترادف با CSAM اما مرکز ملی کودکان گمشده و مورد تعرض قرار گرفته[1] -که کارش کمک به پیدا کردن و نجات بچههای آزاردیده یا گمشده در آمریکاست- CSAM را واژهای میداند که معانی دیگری نیز به همراه دارد. NCMEC به اپل و سایر شرکتهای فناوری اطلاعاتی در خصوص تصاویر CSAM

میدهد. اپل CSAM Detection را در کنار چندین قابلیت دیگر که کارشان توسعه کنترل والدین روی دستگاههای موبایل اپل بود معرفی کرد. برای مثال والدین اگر کسی به فرزندشان عکسی صراحتاً مبتنی بر پورنوگرافی بفرستد (در پیامهای اپل) اول خودشان نوتیفیکیشنها را دریافت خواهند کرد. این رونمایی همزمان از چندین فناوری به نوعی سردرگمی منجر شد و کلی از افراد این حس بهشان القا شد که اپل از حالا قرار است همیشه کاربران خود را تحت نظارت قرار دهد. البته موضوع این نیست.

جدول زمانی انتشار CSAM Detection

CSAM Detection بخشی از iOS 15 و iPadOS 15 خواهد بود که پاییز سال جاری عرضه خواهد شد. گرچه این کارکرد به لحاظ تئوری همهجای دنیا روی دستگاههای موبایل اپل موجود خواهد بود اما اجالتاً تنها در آمریکا کار میکند.

عملکرد CSAM Detection

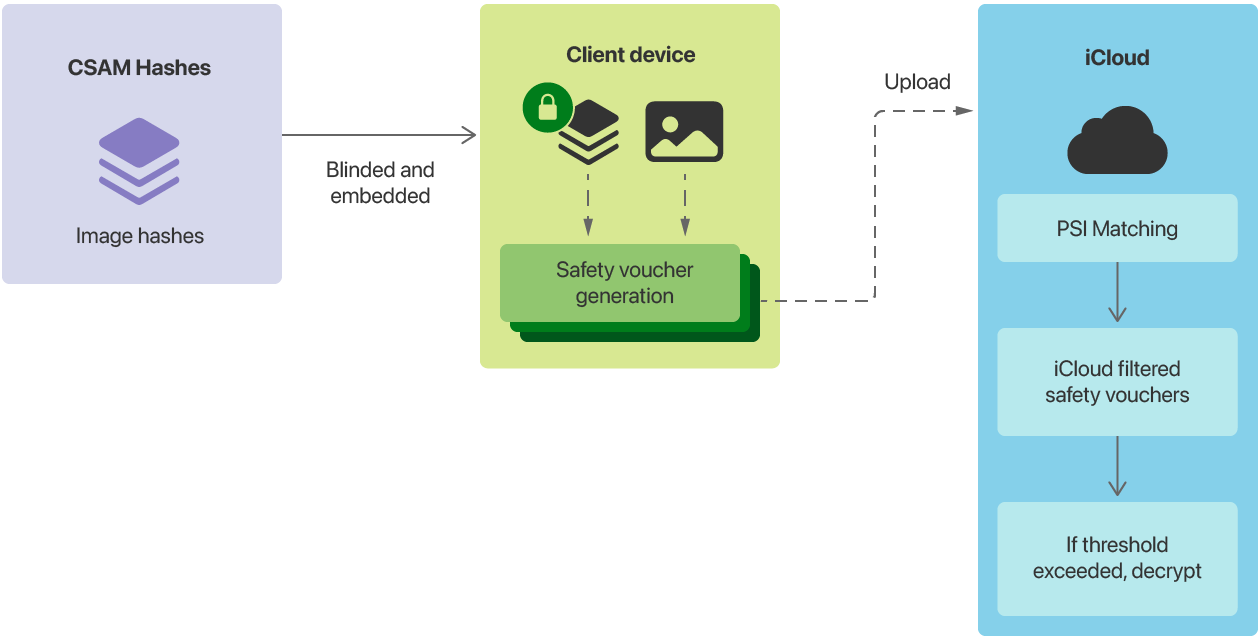

CSAM Detection تنها با عکسهای آیکلود –که بخشی است از سرویس آیکلود که عکسها را از اسمارتفون یا تبلت در سرورهای اپل آپلود میکند- در ارتباط است. همچنین باعث میشود آنها روی سایر دستگاههای کاربر نیز قابلدسترسی باشند. اگر کاربری این همگامسازی عکس را در تنظیمات غیرفعال کند، CSAM Detection از کار خواهد افتاد. این سیستم تعمداً پیچیده طراحی شده است؛ اپل سعی دارد سطح لازمی برای حریم خصوصی تضمین دهد. به نقل از این شرکت، CSAM Detection با اسکن عکسها روی دستگاه کار میکند تا تشخیص دهد با عکسهای داخل پایگاه اطلاعاتی NCMEC یا پایگاه اطلاعاتی سایر سازمانها همخوانی دارند یا خیر.

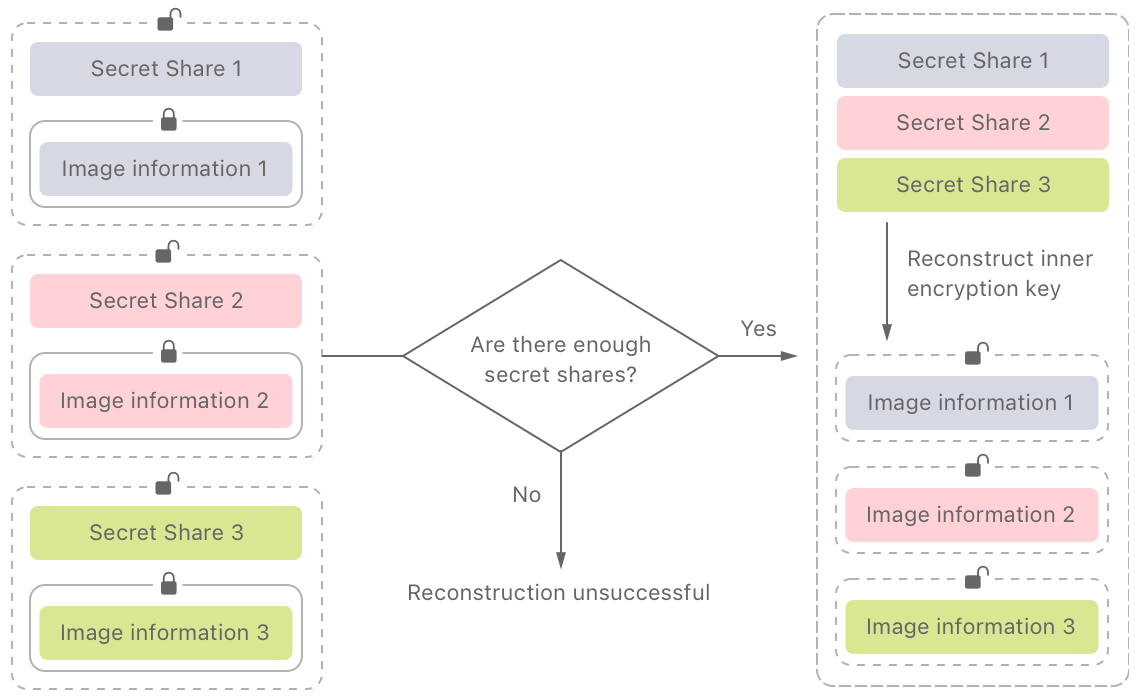

این متود شناسایی از فناوری موسوم به NeuralHash استفاده میکند که در اصل کارش ساخت شناساگرها یا هشهایی است برای عکسهای مبتنی بر محتواهایشان. اگر هشی با یکی از آنها در پایگاه اطلاعاتی تصاویر پورنوگرافی همخوانی داشته باشد، تصویر و هش آن در سرورهای اپل آپلود میشوند. اپل پیش از ثبت رسمی تصویر یک بررسی دیگر انجام میدهد. اجزای دیگر سیستم، فناوری کریپتوگرافی است که همچنین private set intersection نیز نامیده میشود. کار این فناوری رمزگذاری نتایج اسکن CSAM Detection است؛ بطوریکه اپل بتواند آنها را تنها در صورتیکه یک سری معیارها رعایت شود رمزگشایی کند. به لحاظ تئوری این کار باید جلوی سوءاستفاده از سیستم را بگیرد- یعنی باید نگذارد کارمندان شرکت از این سیستم سوءاستفاده کنند و یا بنا به درخواست آژانسهای دولتی آنها را ارائه دهند. در تاریخ 13 آگست وال استرین ژورنال با معاون اسبق بخش مهندسی نرمافزار اپل آقای کریگ فدریگی مصاحبهای انجام داد که طی آن پیرامون تضمین این پروتکل گفتوگو صورت گرفت. 30 عکس باید با عکسهای داخل پایگاه اطلاعاتی NCMEC مطابقت داشته باشد که به اپل هشدار داده شود. همانطور که در نمودار زیر نشان داده شده است، سیستم private set intersection نخواهد گذاشت مجموعه دادهها –اطلاعاتی در مورد عملکرد CSAM Detection و عکسها- رمزگشایی شود (تا زمانی که به آستانه رمزگشایی نزدیک شوند). به نقل از اپل، از آنجایی که آستانه پرچمگذاری یک عکس بالاست بعید است همخوانی کاذبی صورت گیرد.

وقتی سیستم هشدار داده میشود چه اتفاقی میافتد؟ یک کارمند اپل به طور دستی دادهها را بررسی میکند و وجود متریال پورنوگرافی کودکان را تأیید کرده به مقامات مراتب را میرساند. اجالتاً این سیستم تنها در آمریکا کار میکند پس این نوتیفیکیشن به NCMEC–حمایتشده از سوی وزارت دادگستری آمریکا- میرود.

معایب CSAM Detection

دو نقد احتمالی بر اقدامات اپل وارد است: رویکرد این شرکت و آسیبپذیریهای پروتکل مذکور. در حال حاضر هنوز مدارک و شواهدی ال بر اینکه اپل خطای فنی داشته وجود ندارد؛ هرچند شکایایی از این طرف و آنطرف دریافت شده است. به نقل از Electronic Frontier Foundation اپل با افزودن اسکن عکس در سمت کاربر در اصل دارد یک بکدر در دستگاههای کاربران خود جاگذاری میکند. EFF سال 2019 این مفهوم را نقد کرد. چرا این مفهوم میتواند منفی باشد؟ بسیارخوب، فرض کنید دستگاهی دارید که رویش دادهها تماماً رمزگذاری شده است (بنابر گفتههای اپل) و سپس قرار است در خصوص محتواها به خارجیها گزارش دهد. در حال حاضر هدف، محتوای پورنوگرافی کودکان است که به این جمله مشترک ختم شده است: «طلا که پاک است چه منتش به خاک است» اما مادامیکه چنین مکانیزمی وجود دارد نمیتوان دانست روی محتواهای دیگر هم اعمال میشود یا خیر. در نهایت این نقد بیش از اینکه جنبه تکنولوژیکی داشته باشد سیاسی است. مشکل ریشه در فقدان کنتراکت اجتماعی است که بین امنیت و حریم خصوصی تعادل ایجاد کند. همه ما از بوروکراتها گرفته تا سازندگان دستگاه و توسعهدهندگان نرمافزار و فعالان حقوق بشر و کاربران درجهیک سعی داریم این خط تعادل را تعریف کنیم. آژانسهای اجرای قانون شکایت دارند که چنین رمزگذاری شایعی جمعآوری شواهد و دستگیری مجرمان را سختتر میکند و البته قابلفهم هم است.

مشکلات احتمالی ناشی از پیادهسازی CSAM Detection

از دغدغههای اخلاقی که عبور کنیم تازه میرسیم به دستاندازهای تکنولوژیکی. هر کد برنامهای، آسیبپذیریهای جدیدی را تولید میکند. بگذریم که دولتها ممکن است چه کارهایی انجام دهند. اگر یک مجرم سایبری از آسیبپذیریهای CSAM Detection سوءاستفاده کند چه؟ وقتی صحبت از رمزگذاری داده میشود، این نگرانی طبیعی است. اگر محافظت اطلاعات را تضعیف کنید حتی اگر نیتتان هم خیر باشد هر کسی میتواند از این ضعفها برای مقاصد خود سوءاستفاده کند.یک ممیزی مستقل از کد CSAM Detection به تازگی شروع شده است و مدتی هم هست که به طول انجامیده. با این حال از آن چیزهایی دستگیرمان شده است: نخست اینکه کدی که مقایسه عکسها را با مدل ممکن ساخته بود از قبل در نسخه 14.3آیاواس (و مکاواس) موجود بوده است. کاملاً محتمل است که کد بخشی از CSAM Detection است. ابزارهای آزمایش الگوریتم سرچ برای تصاویر مچ از پیش هم با هم تلاقی پیدا کرده بودند. برای مثال الگوریتم NeuralHash اپل نشان میدهد این دو تصویر زیر یک هش واحد دارند:

اگر این امکان وجود دارد که بشود پایگاه اطلاعاتی هشهای عکسهای غیرقانونی را بیرون کشید پس این امکان هم هست که بشود عکسهای بیگناهی را ساخت که هشداری را میدهند- یعنی اپل میتوانست هشدارهای کاذبی دریافت کند تا CSAM Detection ناپایدار شود. شاید دلیل اصلی اینکه اپل این شناسایی را جدا کرده همین باشد (بخشی از این الگورتیم فقط برای پایانه سرور کار میکند). این همچنین تحلیل پروتکل private set intersection اپل است. اساساً شکایت بر سر این است که حتی پیش از رسیدن به آستانه هشدار هم سیستم PSI کلی داده را به سرورهای اپل منتقل میکند. این مقاله سناریویی را شرح میدهد که در آن آژانسهای اجرای قانون از اپل درخواست داده میکنند و این نشان میدهد حتی هشدارهای کاذب هم ممکن است به ملاقات با پلیس منجر شود. اکنون موارد فوق تستهای اولیهای هستند از بررسی خارجی CSAM Detection. موفقیت آنها تا حد زیادی به این بستگی دارد که این شرکت خطمشی شفافی را برای ساز و کار CSAM Detection علیالخصوص کد منبع آن ارائه دهد.

CSAM Detection برای یک کاربر متوسط چه معنایی دارد؟

دستگاههای مدرن آنقدر پیچیدهاند که نمیشود تعیین کرد دقیقاً چقدر امن هستند. کاری که بیشتر ما میتوانیم انجام دهیم اعتماد است –یا عدم اطمینان. با این حال باید این را به خاطر داشت که: CSAM Detection تنها در صورتی عمل میکنند که کاربران در آیکلود عکسهایی را آپلود کرده باشند. تصمیم اپل از سر عمد بوده و در اصل میدانسته یک عدهای با این مفهوم مخالفت میکنند. اگر عکسی را در کلود آپلود نکنید هیچچیز هیچکجا فرستاده نخواهد شد. شاید یادتان باشد که سال 206 بین اپل و افبیآی درگیری پیش آمد. در واقع افبیآی از اپل خواسته بود کمکش کند iPhone 5C را که متعلق بود به یک تیرانداز دستهجمعی در کالیفرنیای آمریکا رمزگشایی کند. افبیآی از اپل خواسته بود نرمافزاری را بنویسد که اجازه دهد این سازمان محافظت پسورد گوشی را در دست گیرد. اما اپل از این کار سر باز زد. سر همینها بود که اپل به حامی 0 تا 100 حریم خصوصی مشتریان خود معروف شد اما حالا با این کار حسابی دارد برای خودش دشمنتراشی میکند. این شرکت مکانیزمی شگرفت ساخت که اتهامات نظارت گسترده کاربران را دفع میکند اما در عوض کلی نقد بدان وارد است (به دلیل اسکن دستگاههای کاربران). در نهایت این قیل و قالها اصل ماجرا را برای کاربری متوسط تغییر نمیدهد. اگر نگران محافظت دادههای خود هستید باید به هر سرویس کلودی شک کنید. دادههایی که روی دستگاه خود ذخیره میکنید هنوز هم جایشان امن است. اقدامات اخیر اپل شک خیلیها را برانگیخته است. اینکه شرکت قرار است به همین رویه ادامه دهد یا خیر هنوز معلوم نیست.

[1] NCMEC

منبع: کسپرسکی آنلاین (ایدکو)

کسپرسکی اسم یکی از بزرگترین شرکتهای امنیتی و سازنده آنتی ویروس است که برخی از کاربران اشتباهاً این شرکت و محصولات آنتی ویروس آن را با عناوینی نظیر کسپرسکای،کاسپرسکی، کسپراسکای، کسپراسکای، و یا کاسپراسکای نیز میشناسد. همچنین لازم به ذکر است مدیرعامل این شرکت نیز یوجین کسپرسکی نام دارد.